|

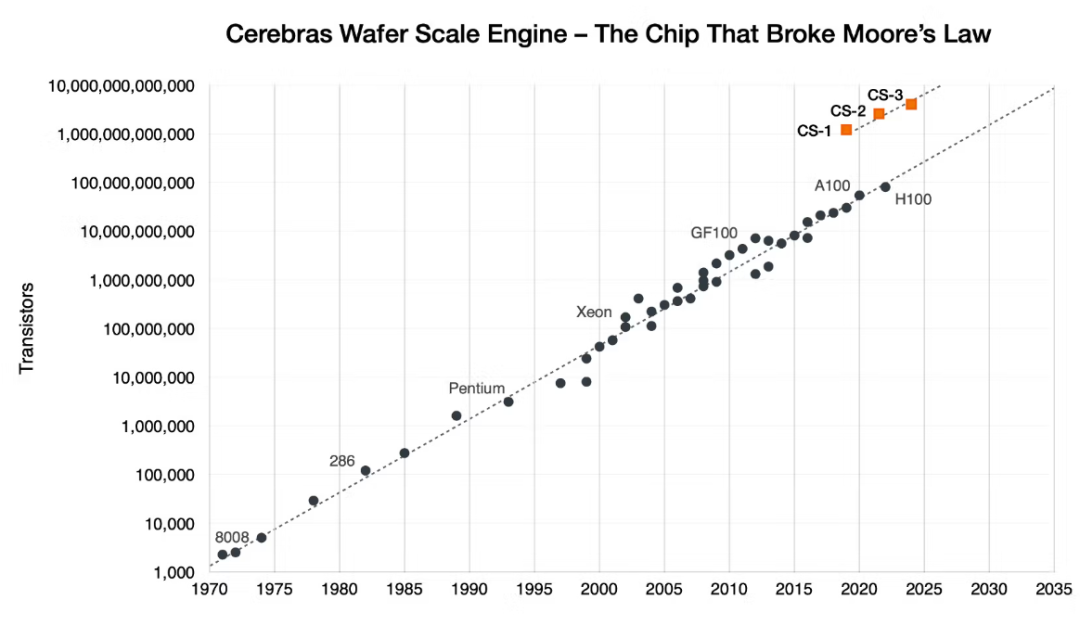

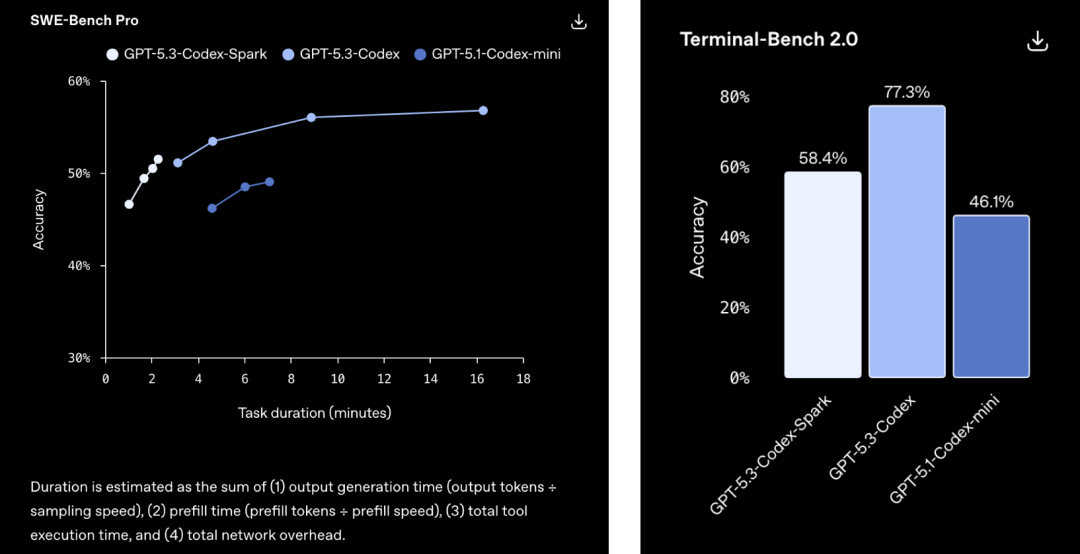

OpenAI又深夜炸场了。 GPT-5.3-Codex-Spark正式发布! 这次不讲大道理,只讲一个字:快。 到底有多快,看一下官方的演示: 它是GPT-5.3家族里的「闪电侠」。 也是OpenAI首个专为实时编程设计的模型,OpenAI称之为「超高速模型」。 大家写代码最烦什么?肯定是等待。 Spark的出现就是为了干掉等待。 它的生成速度超过每秒1000个token! 这是什么概念? 你刚敲完回车,代码已经写完了。 体感接近「瞬时响应」。 这次OpenAI找了个强力外援。 芯片巨头Cerebras。 Spark跑在Cerebras的Wafer Scale Engine 3上。  这不是普通的GPU堆叠。 这是专为低延迟设计的顶级硬件。 为了配合这股怪力,OpenAI还重写了底座。 他们引入了持久的WebSocket连接。 往返开销降低了80%。 首个字符出现的速度提升了50%。 模型虽然变「小」了,但脑子并没缩水。 在衡量程序员能力的各种榜单上。 Spark的表现依然强悍。 最关键的是,它完成任务的时间缩短了一大截。 在评估智能体软件工程能力的SWE-Bench Pro和Terminal-Bench 2.0两项基准测试中,GPT‑5.3‑Codex‑Spark展现出强劲性能,同时完成任务所需时间仅为GPT‑5.3‑Codex的一小部分。  以前模型写代码像在慢跑。 现在Spark是在跑百米冲刺。 它的应用场景很明确:实时协作。 你想改个逻辑,它立刻跟上。 你想重塑接口,它秒速完成。 你甚至可以一边看它写,一边随时打断它。 这种感觉不像是在用工具。 更像是在和一个手速极快的顶级极客结对编程。 配置方面也很有诚意。 128k的上下文窗口,目前仅支持文本。 安全标准也没落下,防御力依然在线。 现在ChatGPT Pro用户已经可以去尝鲜了。 无论是Codex App、CLI还是VS Code插件。 都能看到这个「火花」在跳动。 OpenAI的野心很明显。 未来的编程将分为两种模式。 一种是深度思考,模型自己干几天几夜。 一种是实时互动,模型和你火花四溅。 Spark就是开启第二种模式的钥匙。 人类敲代码的速度。 终于快要赶不上AI生成的进度了。

|